Page 30 - 《原YOUNG—青少年雜誌期刊》114期

P. 30

(AI Act)。 這 部 法 律 保 AI 產品不會對這些社 可能對社會造成傷害。

裡,將 AI 分為不可接受 群產生歧視性的影響。 例如,AI 模型建立之時,

風險、高風險、有限風 尤其在語音辨識與自動 若沒有包含足夠的原住

險以及最低風險的四個 翻譯技術方面,歐盟要 民族的正確資訊,AI 可

等級,並且明確指出哪 求 AI 開發者確保原住民 能無法準確辨認、理解

些 AI 是必須被視為禁止 族語言能夠被 AI 正確識 原住民族文化、語言、

使用,如社會信用評分 別,不會因為數據不完 價值觀等,甚至加劇社

系統、大規模生物識別 整或訓練偏差導致這些 會上的歧視、不平等不

監控等,嚴重侵害人權 語言被忽視。 正義的情形發生。

的類型。

這些框架、法律規 在監管措施上,以

《人工智慧法》對 範等,都是保障 AI 技術 加拿大為例,該國原住

原住民族群也具有重要 不會成為失控的怪獸, 民族僅占全國人口的

影響,尤其是在涉及公 讓 AI 能真的為人類發展 5%(臺灣原住民族人

共數據、語音識別和數 帶來效益。 數占全國人口 2.6%)

字身分管理的領域。該 一樣都是少數族群,

法規定,任何可能影響 AI 的發展需要規範 但加拿大政府確實認知

少數族群的 AI 系統都需 才能走得更遠 到,因為人數少、聲量

要進行公平性測試,確 AI 如果管理不當, 小,所以更需要以國家

力量來確保原住民族的

聲音及觀點被聽見、理

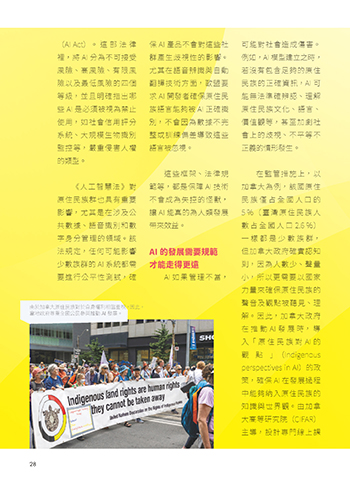

由於加拿大原住民族對於自身權利相當重視,因此,

當地政府尊重全國公民參與推動 AI 發展。

解。因此,加拿大政府

在推動 AI 發展時,導

入「原住民族對 AI 的

觀 點 」(Indigenous

perspectives in AI)的政

策,確保 AI 在發展過程

中能夠納入原住民族的

知識與世界觀。由加拿

大高等研究院(CIFAR)

主導,設計專門線上課

28

ɨʹ

܆݂ࠦԫ JOEE

܆݂ࠦԫ JOEE ɨʹ